Elections et désinformation : quand le discours alarmiste sur l'IA est remis en cause par des chercheurs

Elections et désinformation : quand le discours alarmiste sur l'IA est remis en cause par des chercheurs

Publié le mercredi 21 février 2024 à 11:46

Une affiche pour le candidat argentin Sergio Massa, fabriquée avec l'IA, à Buenos Aires le 3 octobre 2023.

(JUAN MABROMATA / AFP)

- Auteur(s)

Nathan Gallo

Alors que 2024 est une année d'élections, beaucoup d'observateurs ont alerté sur la menace "majeure" de l'IA comme arme de désinformation lors de campagnes électorales. Mais ces dernières semaines, plusieurs chercheurs ont appelé à nuancer les peurs autour de l'IA et souligné la nécessité de penser la désinformation comme un problème politique et non uniquement technologique.

2024, année de campagne électorale… et de nouvelles formes de désinformation ? Cette année, plus de quatre milliards d'électeurs seront appelés aux urnes pour cette année décrite par The Economist comme "la plus grosse année d'élections de l'histoire".

Mais de nombreux observateurs s'inquiètent des menaces qui planent sur l'intégrité de ces différents scrutins. En cause notamment : l'arrivée de nouveaux outils de génération de contenus par intelligence artificielle (IA), à même de provoquer la diffusion massive de fausses informations en tout genre, des deepfakes aux photos manipulées.

"Les contenus synthétiques vont manipuler les individus"

Ces derniers mois, plusieurs de ces contenus ont été repérés lors de scrutins dans plusieurs pays. En Argentine, les deux candidats à l'élection présidentielle de novembre dernier Javier Milei et Sergio Massa, qui ont par ailleurs utilisé l'IA pour des spots et affiches de campagne, ont été tous deux victimes de deepfakes, raconte le Courrier International.

Une situation qui a poussé le New York Times à se demander si cette élection argentine n'avait pas été "la première élection générée par IA".

Aux Etats-Unis, de nombreux électeurs du New Hampshire ont même indiqué avoir reçu fin janvier, en pleine primaire démocrate, l'appel d'une fausse voix (un deepvoice) se faisant passer pour le président américain Joe Biden les appelant à ne pas aller voter.

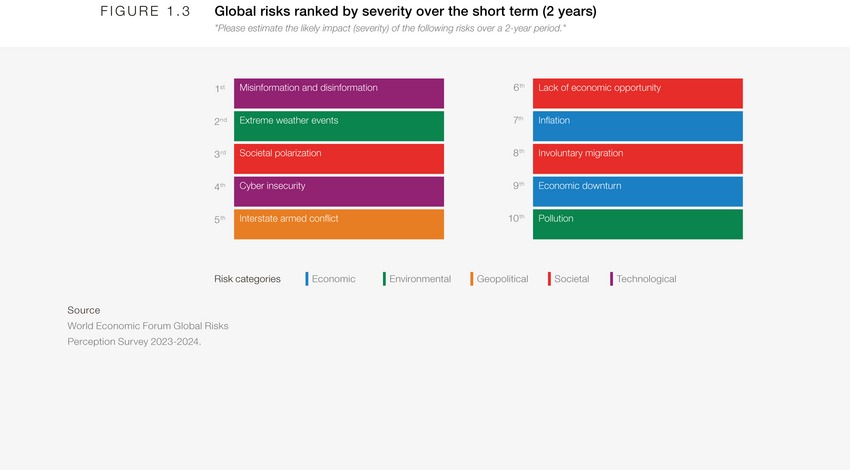

Autant de situations qui poussent de nombreux observateurs à dénoncer le potentiel nuisible de l'IA dans l'intégrité des élections. Début janvier, la désinformation a même été classée comme le principal "risque" à l'échelle mondiale à court-terme par les acteurs économiques interrogés en janvier par le Forum économique mondial, pour un sondage publié dans son rapport annuel d'évaluation des risques à l'échelle mondiale.

Dans le rapport publié le 10 janvier par le Forum économique mondial sur les résultats du sondage, l'organisation affirme que "les contenus synthétiques vont manipuler les individus, nuire aux économies et fracturer les sociétés de multiples manières" dans les deux prochaines années, voire provoquer "l'effondrement de l'Etat dans les cas les plus extrêmes" si la "légitimité des élections [était] remise en cause".

"Considérer l'IA comme une menace retire la responsabilité au système politique"

Ces résultats ont toutefois suscité des débats au sein de la communauté scientifique, alors que plusieurs chercheurs en communication politique et sciences cognitives ont appelé à changer la focale sur le sujet.

"ll est trompeur d'affirmer que la principale menace réside dans les nouvelles technologies numériques", observe notamment l'universitaire Johan Farkas auprès de DE FACTO. Ce chercheur de l'université de Copenhague, auteur du livre "Post-Truth, Fake News and Democracy", fait partie des nombreux universitaires à avoir ouvertement critiqué les résultats de ce sondage sur X (ex-Twitter), considéré comme le symbole d'un déni sur les ressorts politiques de la désinformation.

Rejetant le "discours techno-déterministe" vis-à-vis de l'IA, Johan Farkas explique que "considérer l'IA comme une menace retire la responsabilité de la désinformation au système politique".

Un point aussi souligné par le directeur du Reuters Institute for the Study of Journalism (RISJ), centre de recherche pionnier sur l'analyse des médias. "Les résultats de recherche soulignent sans cesse l'impact réel de la politique, tandis que les documents politiques se concentrent constamment sur l'impact possible des nouvelles technologies", a-t-il déclaré dans une tribune au Financial Times le 2 janvier.

Dans l'ouvrage publié en 2018 et devenu référence sur les mécanismes de circulation de la désinformation "Network Propaganda", les chercheurs Jochai Benkler, Robert Faris et Hal Roberts ont analysé la manière dont Donald Trump, alors candidat à la présidentielle américaine en 2016, et les médias conservateurs comme Fox News qui l'ont soutenu ont ainsi été un vecteur majeur de désinformation dans les semaines et mois avant le scrutin.

Pour Rasmus Nielsen, ces fausses informations issues du monde politique sont "susceptibles d'avoir un impact beaucoup plus important que celles provenant d'autres sources", que ce soient les publications d'internautes ordinaires ou de campagnes malveillantes. "Les gens prêtent plus d'attention à ce que disent les personnalités politiques de premier plan, et leurs partisans sont plus enclins à y croire et à agir en conséquence".

"Il faut traiter le sujet de la désinformation, mais je suis sceptique quant à la nouveauté de ce concept, comme s'il s'agissait d'aborder un enjeu complètement nouveau", souligne de son côté Johan Farkas.

Ce dernier rappelle que plusieurs conséquences régulièrement attribuées à la désinformation sur les réseaux sociaux, comme la baisse de confiance dans les institutions, n'est pas un phénomène nouveau. "Aux Etats-Unis, les sondages rappellent que la baisse de confiance dans les institutions baisse depuis les années soixante".

Une peur sur l'IA "exagérée" ?

Face aux résultats du sondage du Forum économique mondial, d'autres chercheurs ont aussi appelé à nuancer les peurs liées à la désinformation fabriquée par IA.

Sur X, le chercheur au Oxford Internet Institute Felix Simon s'est montré sceptique, expliquant que "les preuves qu'une 'vague de désinformation artificielle' pourrait faire une différence majeure dans les élections de cette année (par rapport à d'autres facteurs) sont extrêmement minces".

Avec les chercheurs Sacha Altay et Hugo Mercier, Felix Simon a publié en octobre un article dans la Harvard Kennedy School review estimant que "les craintes sur l'impact de l'IA générative sur la désinformation sont exagérées".

Dans cette étude, les universitaires, qui se sont appuyés sur de nombreux travaux de recherche en sciences cognitives, et en science politique et de la communication, expliquent qu'il est peu probable que l'augmentation en quantité et en qualité de la désinformation en ligne via l'IA bouleverse l'écosystème informationnel ou n'altère fondamentalement notre vision du monde, contrairement aux discours ambiants.

En cause notamment : la réception des fausses informations sur le public. "Ce n'est pas parce qu'il y a plus de mésinformation que les gens vont nécessairement plus en consommer", soutiennent les trois universitaires, qui affirment que "la consommation de mésinformation est surtout limitée par la demande et non par l'offre".

"Nous avons un temps d'attention limité, qui limite notre consommation globale d'informations", précise Felix Simon à DE FACTO. "Il faut donc d'abord que cette nouvelle désinformation atteigne son public cible", explique-t-il, rappelant qu'internet est déjà rempli de désinformation.

"Ce n'est pas parce qu'il y a plus de mésinformation disponible du fait de l'IA qu'elle a un plus gros impact. Car à l'origine, il est difficile de toucher des gens et de les convaincre", décrit Felix Simon, qui estime que "la demande de désinformation est déjà satisfaite par ce qui existe déjà. Et il n'y a pas de raison particulière que la désinformation générée par IA soit significativement plus efficace pour toucher plus de monde".

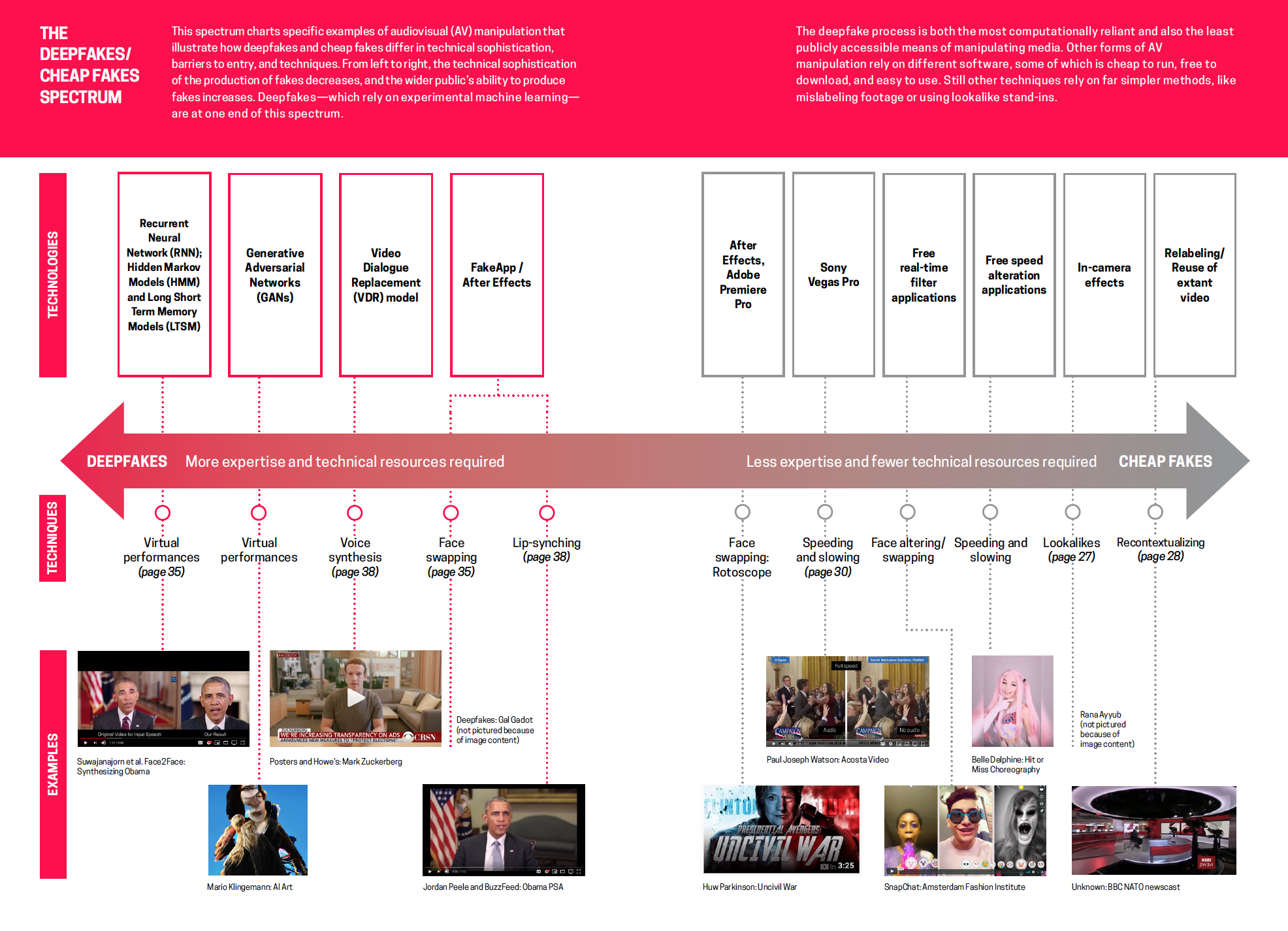

Deepfakes VS cheapfakes

Pour plusieurs spécialistes de la désinformation, comme Britt Paris et Joan Donovan à l'origine du terme "cheap fake" pour désigner de fausses informations produites à partir de faibles moyens technologiques, une bonne intox n'est en effet pas simplement une affaire de qualité.

"La création de contenus trompeurs n'a jamais nécessité de technologies de traitement avancées", racontent les deux chercheuses dans un article publié en 2019, quelques années avant la démocratisation des outils mobilisant l'IA.

Mais cette analyse peut aussi s'appliquer à l'IA aux yeux d'autres observateurs. Dans une tribune publiée début janvier, Alex Mahadevan, directeur du projet d'éducation aux médias du Poynter Institute MediaWise, avait notamment affirmé ne pas voir "l'IA générative supplanter les fakes bon marché, les mêmes stupides ou les déclarations politiques en tant que principaux vecteurs de désinformation".

La désinformation générée par IA pourrait-t-elle tout de même s'avérer plus convaincante que des fausses informations de mauvaise qualité ? "Nous avons pour le moment peu de preuves que le pouvoir de persuasion de ce type d'information est plus fort que ce qui existe actuellement", nuance aussi Felix Simon.

Ce dernier rappelle que "le contexte dans lequel un internaute est confronté à une fausse information est souvent central, tout comme ses a priori. Ce n'est pas uniquement parce qu'un contenu faux est de bonne qualité que je vais nécessairement le croire", explique-t-il.

Plus globalement, Felix Simon estime nécessaire de ne pas tirer de conclusions hâtives sur les effets de l'IA et de la désinformation en général. "Il existe beaucoup d'autres raisons pour lesquelles les gens pensent ce qu'ils pensent. Il ne faut donc pas se concentrer uniquement sur la désinformation, et ne pas ignorer les causes politiques, culturelles et économiques à l'origine par exemple de comportements anti-démocratiques".

"Le temps nous dira si les titres alarmistes sur l'IA générative sont justifiés ou non"

La question de la menace soulevée par les fausses informations générées par IA suscite toutefois encore des discussions au sein de la communauté scientifique et sur X, alors qu'un manque de consensus existe autour de l'impact réel de la désinformation sur nos sociétés.

Dans un article publié par la revue Brookings fin janvier, les chercheurs Zeve Sanderson, Solomon Messing et Joshua Tucker essayent de trouver une voie médiane, et estiment que l'IA pourrait tout de même produire des contenus plus persuasifs. "La société a probablement surestimé à l'origine l'impact de la désinformation en ligne, et nous voulons être attentifs à la possibilité de commettre la même erreur avec la désinformation générée par l'IA", indiquent les chercheurs.

"Mais cela n'enlève rien à la capacité de l'IA à modifier l'équation et à compromettre potentiellement les élections", soulignent-t-ils, appelant notamment à tester l'hypothèse selon laquelle la désinformation liée à l'IA pourrait être plus dangereuse lors de futurs scrutins.

"Le temps nous dira si les titres alarmistes sur l'IA générative sont justifiés ou non", conclut Felix Simon. "Mais quelle que soit l'issue, le débat sur l'impact de l'IA générative sur la désinformation gagnerait à être plus nuancé et fondé sur des données probantes, en particulier dans le contexte des efforts réglementaires en cours".

Ce fact-check a été publié par DE FACTO.