La transparence des plateformes. Oui, mais comment ? De quelles données a besoin la recherche sur la désinformation ? - Policy brief

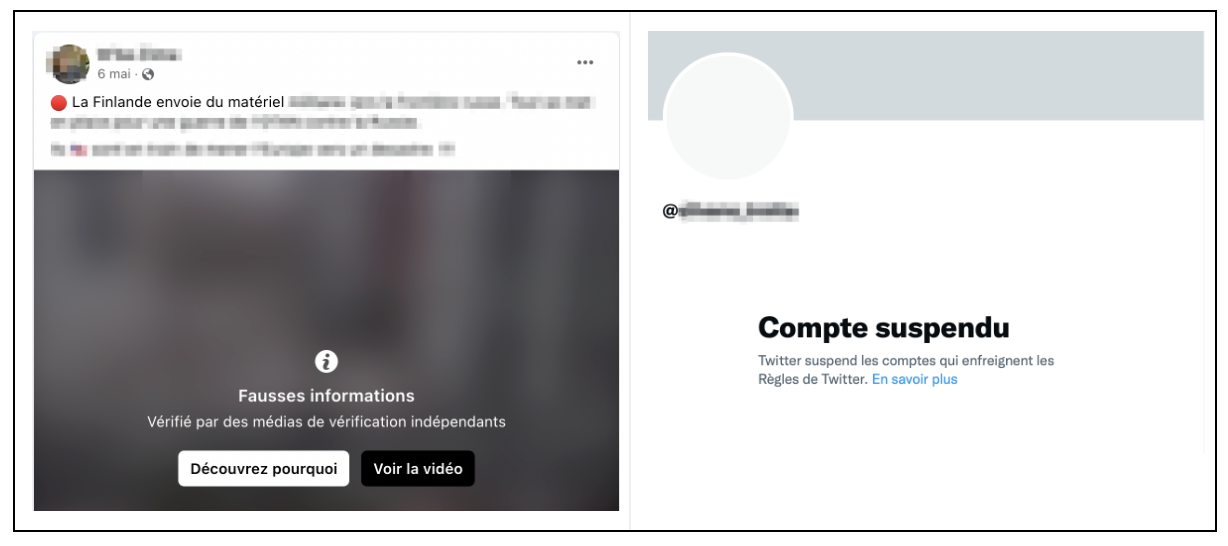

Facebook, Twitter ou YouTube font-ils bien ce qu’ils disent faire en matière de modération des contenus relatifs à la désinformation ou aux discours de haine ? Des bandeaux apparaissent sous certains contenus, des comptes ou des groupes disparaissent ou voient leur visibilité diminuer. Mais tous les contenus du même type sont-ils soumis au même traitement ? Quelles explications sont données par les plateformes aux utilisateurs qu’elles sanctionnent ? Les politiques de modération sont difficiles à étudier et à auditer par des tiers, comme la communauté académique, les journalistes ou les ONG. Dans de nombreux cas, le contenu erroné ou faux ne constitue pas une violation des règles des plateformes et n'apparaît pas explicitement comme une catégorie distincte dans les rapports de transparence disponibles. En raison du rôle désormais central qu’elles jouent dans la formation de l’opinion publique, l’opacité des plateformes constitue un problème public majeur. Depuis 2016, lorsque le Brexit, l’élection de Donald Trump et de Jair Bolsonaro ont mis la question de la désinformation à l’ordre du jour, les grandes plateformes ont initié de nombreuses politiques internes pour réduire les désordres informationnels dont elles s’étaient rendues responsables. Mais comment des chercheurs peuvent-ils le vérifier de façon indépendante et rigoureuse ?

Pour le faire aujourd’hui, les chercheurs utilisent des techniques d’audit à partir de méthodes de scrapping, des outils existants pour accéder aux données à travers les API des plateformes ou, pour Facebook, au moyen d’une interface offrant aux chercheurs un accès restreint à des données limitées et anonymisées. Ce rapport montre que, même s’il est possible de tirer des constats importants à partir de ces données, elles restent cependant très largement incomplètes, insuffisantes et mal expliquées pour conduire une observation indépendante et rigoureuse de la politique des plateformes.

Le contexte dans lequel les chercheurs ont mis en place ces travaux va se modifier profondément. La mise en œuvre prochaine du Digital Service Act européen confie au régulateur le soin de procéder à un “audit systémique” des grandes plateformes notamment en ce qui concerne les actions qu’elles mènent sur les questions de désinformation et de discours de haine. Il invite aussi à établir un cadre juridique permettant aux chercheurs d’accéder aux données des plateformes. Dans ce contexte, un groupe de travail de l’European digital media observatory (EDMO) et de l’Institute for Data, Democracy & Politics (IDDP) de George Washington University vient de publier le document préparatoire d’un “Code of Conduct for Platform-to-Researcher Data Sharing ”. Il propose une gouvernance solide et conforme aux textes européens pour mettre en place l’accès aux données des grandes plateformes par les chercheurs indépendants, dans le respect du RGPD. En France, l’Arcom, a qui a été confié la tâche de mettre en œuvre le DSA, vient de lancer une consultation publique à destination des chercheurs et des ONG pour recueillir les besoins et les questions qu’ils souhaitent poser aux données des plateformes.

La modification du contexte réglementaire invite à dépasser la formulation d’une simple demande incantatoire de transparence des plateformes. L’heure est à la formulation de propositions réalistes pour mettre concrètement en œuvre des procédures permettant de comprendre, d’observer rigoureusement et d’étudier de façon indépendante le travail des plateformes. Ce document voudrait participer à ce débat en détaillant précisément ce dont les chercheurs ont besoin : Quelles données ? Pour quoi faire ? Comment gouverner ce transfert de données ? Régulateur, plateformes, chercheurs et autres acteurs de la société civile doivent maintenant construire un cadre original afin que les politiques des plateformes n’apparaissent plus opaques et arbitraires, mais qu’elles fassent l’objet d’un examen public et transparent.

Dominique Cardon

Lien vers la publication complète

https://hal-sciencespo.archives-ouvertes.fr/hal-03711842

Auteurs

Shaden Shabayek, Emmanuel Vincent and Héloïse Théro

Sciences Po médialab