Les "appels à la révolte" bientôt "censurés" sur les réseaux sociaux ? Pas si simple

Les "appels à la révolte" bientôt "censurés" sur les réseaux sociaux ? Pas si simple

Publié le jeudi 20 juillet 2023 à 10:39

(DENIS CHARLET / AFP)

© AGENCE FRANCE-PRESSE | 2024 | Tous droits réservés.

- Auteur(s)

Bénédicte REY / AFP France

A partir du 25 août 2023, les grandes plateformes numériques comme Facebook, Twitter ou Instagram vont être soumises à de nouvelles obligations avec l'entrée en vigueur d'un règlement européen, le Digital Services Act (DSA), visant à mieux lutter contre les contenus illicites en ligne, tels que les appels à la haine ou la vente de produits illégaux.

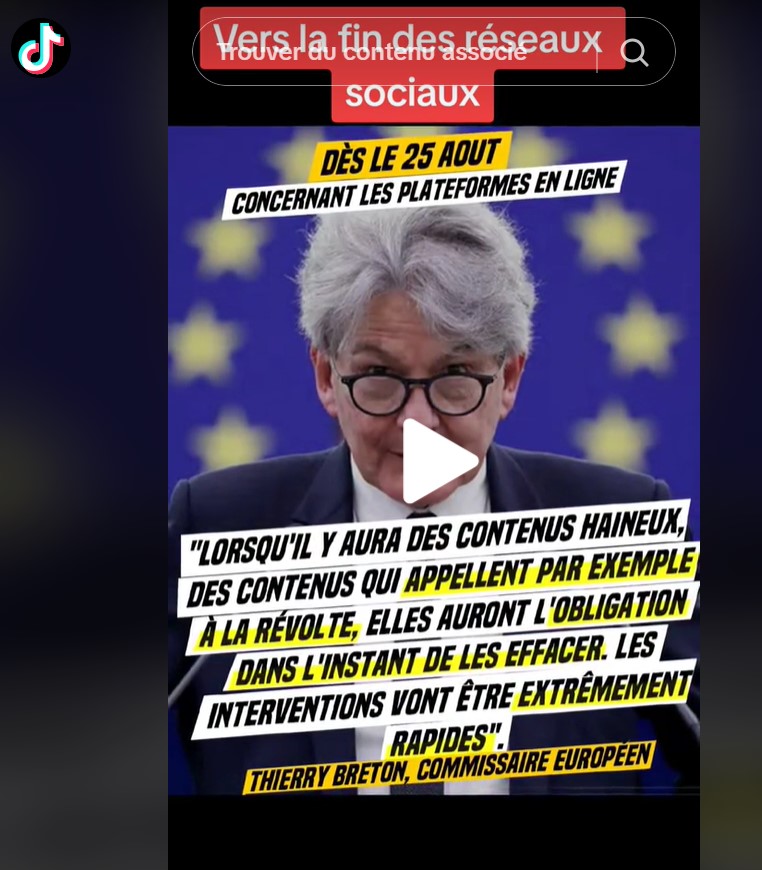

Dans un entretien à France Info, le 10 juillet, le Commissaire européen Thierry Breton a affirmé que les plateformes auront désormais l'obligation d'effacer "dans l'instant" les contenus "appelant à la révolte". Cette expression a provoqué l'indignation de nombreux internautes, qui y voient une atteinte à la liberté d'expression et l'instauration d'une "censure". Selon plusieurs juristes interrogés par l'AFP, les propos de M. Breton sont en partie ambigus et ont pu prêter à confusion. Le DSA renforce les obligations des plateformes mais ne prévoit pas l'interdiction de contenus autres que ceux déjà définis comme illicites dans le droit européen ou français. Selon ces spécialistes, "l'appel à la révolte" n'en fait pas partie à l'heure actuelle. Pour autant, si le DSA prévoit des garde-fous pour protéger la liberté d'expression, des incertitudes demeurent sur les mesures que prendront les plateformes face à des contenus dont le caractère illicite n'est pas immédiatement évident, pointent certains experts.

Invité de France Info le 10 juillet, Thierry Breton, commissaire européen au Marché intérieur, a été interrogé sur le rôle des réseaux sociaux lors des émeutes consécutives à la mort du jeune Nahel fin juin. Les violences urbaines ayant suivi le décès du jeune homme, tué fin juin par un tir policier lors d'un contrôle routier à Nanterre (Hauts-de-Seine), avaient été relayées en masse sur internet.

Le gouvernement avait alors demandé aux plateformes "d'organiser le retrait des contenus les plus sensibles", aboutissant à la suppression de "milliers de contenus illicites" et à la suspension de "centaines de comptes" (lien archivé ici).

Pourtant, "les réseaux sociaux n'ont pas fait assez et il va falloir qu'ils fassent plus", a estimé M. Breton lors de son interview sur France Info (lien archivé ici). "A partir du 25 août, ceci ne pourra plus se produire [...]. La loi européenne va s'appliquer à ces plateformes, c'est-à-dire que lorsqu'il y aura des contenus haineux, des contenus qui appellent par exemple à la révolte, qui appellent à tuer des individus ou à brûler des voitures, elles auront l'obligation dans l'instant de les effacer. Si elles ne le font pas, elles seront immédiatement sanctionnées, on a des équipes qui vont intervenir immédiatement. Si elle n'agissent pas immédiatement, on pourra à ce moment là non seulement leur donner une amende mais interdire l'exploitation sur notre territoire", a-t-il déclaré.

La déclaration de Thierry Breton sur la suppression de contenus appelant "à la révolte" a depuis été partagée des milliers de fois sur les réseaux sociaux (ici ou ici) et de nombreux internautes y ont vu l'instauration d'une forme de "censure" et la "fin des réseaux sociaux" (ici, ici ou ici).

Qu'en est-il exactement ? Pour les spécialistes interrogés par l'AFP, les propos de Thierry Breton sont ambigus car le DSA ne modifie pas les catégories de contenus déjà illicites en ligne et hors ligne et "l'appel à la révolte" n'en fait pas explicitement partie à l'heure actuelle en France. Le DSA prévoit bien des sanctions alourdies pour les plateformes en cas de manquements, mais celles-ci ne seront pas immédiates. D'autre part, le règlement prévoit des garde-fous pour protéger la liberté d'expression et des possibilités de recours, judiciaires et extra-judiciaires, pour les utilisateurs qui s'estimeraient censurés.

Capture d'écran effectuée sur Twitter le 13 juillet 2023

Capture d'écran effectuée sur Tik Tok le 13 juillet 2023

"C'est une déclaration politique un peu à l'emporte-pièce et les réactions sont à l'avenant. Il n'y a pas cette possibilité [de supprimer les appels à la révolte, NDLR] dans le DSA et il n'y a pas de censure d'internet", estime ainsi Vincent Varet, avocat-associé du cabinet Varet-Près-Killy et professeur associé à l'Université Paris-Panthéon-Assas en propriété intellectuelle et droit du numérique, interrogé le 13 juillet 2023 par l'AFP (lien archivé ici).

"Le DSA ne permet absolument pas de faire ce que dit Thierry Breton", abonde Bastien Le Querrec, juriste et membre de l'association de défense des libertés sur internet la Quadrature du net, interrogé par l'AFP le 13 juillet 2023. En matière de modération de contenus, le DSA "ne change fondamentalement pas grand chose" à la législation existante.

Pas de sanctions "immédiates"

Signé en octobre 2022 par le Parlement et le Conseil européens, le règlement sur les services numériques (Digital Services Act en anglais, ou DSA) vise à "protéger les utilisateurs en ligne contre les contenus illicites, dangereux et préjudiciables", explique sur son site le ministère de l'Economie français (lien archivé ici), qui précise que cette législation "consacre le principe que ce qui est illégal hors ligne est également illégal en ligne". Toutes les plateformes devront s'y conformer, quelle que soit leur taille, à partir du 1er janvier 2024.

Elle devront notamment "être transparentes quant à leurs politiques de modération de contenus, leurs systèmes de recommandation et la publicité qu'elles diffusent, garantir les droits des utilisateurs via des mécanismes de signalement et de traitement interne des réclamations, prendre des mesures renforcées de protection des mineurs en ligne", précise le ministère.

Dès le 25 août, des obligations spécifiques s'appliqueront aux grandes plateformes (lien archivé ici), comptant plus de 45 millions d'utilisateurs actifs par mois en Europe, parmi lesquelles figurent Instagram, Tik Tok, Snapchat, Facebook, Twitter, LinkedIn, YouTube, Alibaba, Amazon ou encore Booking.

"En raison de leur taille et de l'impact potentiel qu'[elles] peuvent avoir sur la société", elles devront "identifier, analyser et évaluer les risques systémiques liés à leurs services", notamment ceux liés aux contenus illégaux, aux "droits fondamentaux, tels que la liberté d'expression, la liberté et le pluralisme des médias, la discrimination, la protection des consommateurs et les droits de l'enfant", à la "sécurité publique et aux processus électoraux", à la "violence sexiste, la santé publique, la protection des mineurs, et le bien-être mental et physique", explique la Commission sur son site (lien archivé ici). Les plateformes seront tenues d'"atténuer ces risques".

En cas de manquements, les plateformes s'exposent à un amende pouvant aller jusqu'à 6% de leur chiffre d'affaires mondial, voire à une mesure temporaire de restriction de l'accès au service dans les cas les plus graves.

"Le texte ne prévoit nullement la possibilité de fermer les réseaux sociaux, en tout cas de manière immédiate et automatique, ni même de leur imposer de bloquer de manière immédiate n'importe quel type de contenus", analyse Me Varet. "En réalité, les très grandes plateformes vont avoir des obligations d'évaluation des risques systémiques qu'elles peuvent faire courir à l'égard notamment de la démocratie. C'est un travail d'évaluation d'abord et ensuite de mise en place de mesures d'atténuation des risques. On est dans une logique de temps long, pas du tout dans la réaction immédiate face à des contenus illicites".

Le règlement prévoit que "les algorithmes des plateformes, leurs règles de fonctionnement, leur règlement intérieur, le fonctionnement de leurs services soient audités chaque année, à la fois en interne, mais aussi par un auditeur extérieur indépendant", explique Vincent Couronne, enseignant-chercheur à l'Université Paris-Saclay et directeur de l'association les Surligneurs, qui vérifie la conformité au droit des propos tenus par les personnalités publiques (lien archivé ici).

Si ces plateformes ne respectent pas les règles fixées par le DSA, "elles s'exposeront à des mises en demeure de la Commission européenne, voire à des amendes et éventuellement, en bout de course, à ce qu'un juge prononce leur fermeture temporaire en Europe. Mais, c'est sur le moyen ou le long terme pour des problèmes vraiment systémiques", détaille-t-il dans un entretien à l'AFP le 12 juillet 2023.

Le DSA ne définit pas de nouveaux contenus illicites

"La modération ou même la suppression de contenus n'est pas quelque chose qui est inventé par le DSA. C'est quelque chose qui a été mis en place par une directive en 2000 et qui a été transposé dans la législation française par la loi pour la confiance dans l'économie numérique en 2004", rappelle Alexandra Iteanu, avocate au barreau de Paris, responsable du pôle data et RGPD (Réglèment général sur la protection des données), au sein du cabinet ITEANU Avocats, interrogée le 13 juillet 2023 par l'AFP (lien archivé ici).

"La modération de contenus est renforcée dans le DSA avec notamment l'obligation [pour les plateformes, NDLR] de mettre en place un mécanisme de notification pour que les utilisateurs puissent alerter la plateforme en cas de contenus illicites. Si la plateforme a connaissance de ce contenu illicite, elle est dans l'obligation de le retirer", explique Me Iteanu.

"Pendant les émeutes, il y a eu des appels à la violence, aux dégradations, à aller saccager des magasins qui étaient effectivement des contenus illicites. Les plateformes devaient déjà les retirer. Le DSA va juste rendre ces obligations beaucoup plus contraignantes, avec des amendes possibles beaucoup plus fortes que jusqu'à présent", ajoute M. Couronne.

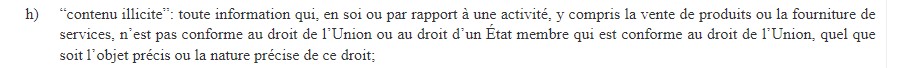

Dans son article 3 (lien archivé ici), le DSA définit un "contenu illicite" comme "toute information qui, en soi ou par rapport à une activité, y compris la vente de produits ou la fourniture de services, n’est pas conforme au droit de l’Union ou au droit d’un État membre qui est conforme au droit de l’Union, quel que soit l’objet précis ou la nature précise de ce droit".

"Il peut s’agir, par exemple, du partage d’images représentant des abus sexuels commis sur des enfants, du partage illégal d’images privées sans consentement, du harcèlement en ligne, de la vente de produits non conformes ou contrefaits, de la vente de produits ou de la fourniture de services en violation du droit en matière de protection des consommateurs, de l’utilisation non autorisée de matériel protégé par le droit d’auteur, de l’offre illégale de services de logement ou de la vente illégale d’animaux vivants. En revanche, la vidéo d’un témoin oculaire d’une infraction pénale potentielle ne devrait pas être considérée comme constituant un contenu illicite simplement parce qu’elle met en scène un acte illégal, lorsque l’enregistrement ou la diffusion au public d’une telle vidéo n’est pas illégal en vertu du droit national ou du droit de l’Union", précise le texte du règlement.

Extrait de l'article 3 du Digital Services act

"Le DSA ne définit pas ce qu'est un contenu illégal. Il s'appuie sur les lois de l'Union européenne ou nationales, y compris celles applicables en France", indique la Commission européenne, interrogée le 12 juillet 2023 par l'AFP.

"Par exemple, le contenu terroriste, le matériel pédopornographique ou les discours de haine illégaux sont considérés comme des contenus illégaux dans tous les pays de l'Union européenne, tandis que dans la plupart des pays de l'UE, l'incitation à la haine ou à commettre un crime est également considérée comme illégale. Le DSA n'interfère pas avec les lois nationales ou européennes qui spécifient ce qui est illégal, mais il comprendra des mesures harmonisées sur la manière dont les plateformes et autres intermédiaires doivent traiter les contenus, biens ou services qui sont illégaux selon les lois de l'UE ou nationales".

"L'appel à la révolte" peut-il être considéré comme un contenu illicite ?

En droit européen, "ce qui est interdit, c'est essentiellement l'apologie de crime contre l'humanité, ce sont les fraudes commerciales, la pédopornographie, le racisme...", détaille M. Couronne. En droit français, "c'est essentiellement ce qu'on trouve dans la loi de 1881 sur la liberté de la presse", ajoute-t-il.

Cette loi du 29 juillet 1881 (lien archivé ici) prohibe notamment l'apologie de crimes, comme les crimes de guerre ou les crimes contre l'humanité, l'incitation à la violence, à la haine, à la discrimination, à la haine à l'égard d'un personne ou d'un groupe de personnes, la provocation aux vols, aux destructions ou aux dégradations. Mais l'appel à la "révolte" n'y figure pas explicitement.

"L'appel à la révolte n'est pas illicite en soi, s'il s'agit simplement d'un appel à la manifestation, à la désobéissance civile. Il faudrait un appel à la révolte qui contienne une incitation à la violence à l'égard d'une personne ou d'un groupe de personnes pour que cela devienne illicite", estime M. Couronne.

La loi de 1881 prévoit également l'interdiction du tout "cri ou chant séditieux". "Mais, il faudrait que ce soit des personnes qui appellent explicitement sur les réseaux sociaux à renverser le pouvoir et qu'elles aient les moyens de commencer à faire ce qu'elles appellent à faire, donc d'organiser vraiment la sédition. Si un anonyme sur Twitter écrit +il faut renverser Macron+, je ne vois pas comment un juge pourrait accepter tout de suite qu'on retire le contenu, qu'on lui ferme son compte, qu'on le traduise en justice pour sédition", ajoute-t-il.

Sont aussi interdits la provocation aux crimes et délits qui "portent atteinte aux intérêts fondamentaux de la Nation" définis dans le Code pénal par des infractions comme la trahison, l'espionnage, ou le mouvement insurrectionnel, c'est-à-dire une "violence collective de nature à mettre en péril les institutions de la République ou à porter atteinte à l'intégrité du territoire national".

"Il serait possible de demander à un réseau social de supprimer des propos qui seraient une provocation directe à des faits qui pourraient être qualifiés de mouvement insurrectionnel, mais seulement s'ils répondent à cette qualification de façon manifeste, ce qui suppose d'apprécier si les conditions sont remplies. Ce ne sera pas toujours évident et donc la plateforme pourra dire : je ne suspends pas parce que je considère que l'infraction n'est pas manifestement constituée. En réalité, il y a toujours le contrôle d'un juge", note Me Varet.

En effet, "le Conseil constitutionnel a jugé en 2004 à propos de la loi pour la confiance dans l'économie numérique que les prestataires d'hébergement n'avaient l'obligation de supprimer que les contenus manifestement illicites, c'est-à-dire évidemment illicites. Cela a été repris depuis par la loi française et le DSA va être interprété de la même façon", rappelle Me Varet. "L'idée, c'est qu'un opérateur économique quel qu'il soit n'a pas à juger lui-même de la licéité ou de l'illicéité d'un contenu. Si ce n'est pas évident, il ne peut pas suspendre".

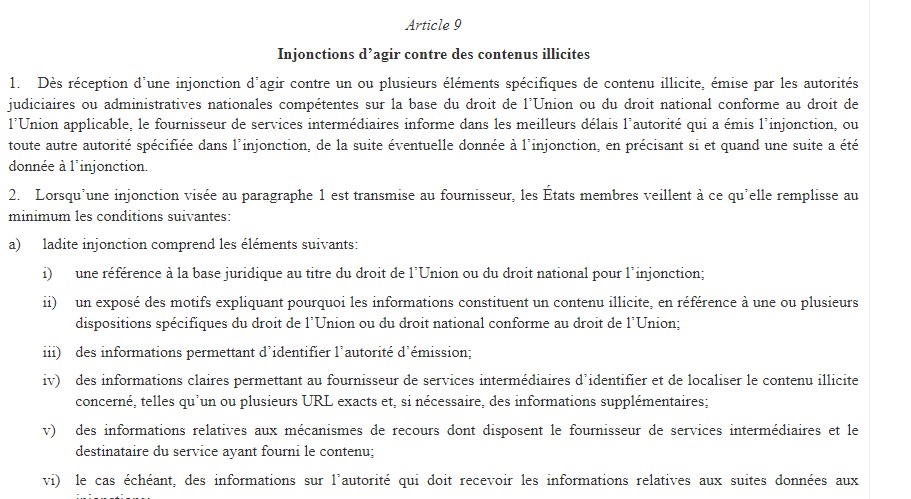

La question des injonctions administratives

Le règlement précise que les plateformes ne sont soumises à aucune obligation de surveiller les informations qu'elles transmettent ou stockent, ni ne sont tenues de rechercher activement de contenus illégaux. Ceux-ci doivent en revanche pouvoir leur être signalés par n'importe quel utilisateur. L'article 9 du DSA prévoit également qu'elles puissent être enjointes par les autorités judiciaires ou administratives à supprimer un contenu illicite.

Ce dispositif pourrait-il permettre à l'Etat d'exiger la suppression d'un message appelant à la révolte ?

L'article 9 précise que les autorités judiciaires et administratives doivent, dans ce cas, "justifier la base légale de cette demande, c'est-à-dire le caractère illicite du contenu", souligne Me Iteanu. Le règlement prévoit en outre des possibilités de recours, notamment que les plateformes mettent en place des systèmes de réclamation pour contester un retrait.

Extrait de l'article 9 du Digital Services Act

"Ce système d'injonction n'est pas suffisant en lui seul. L'article 9 prévoit juste ce mécanisme d'injonction qui peut être mobilisé si le droit européen ou le droit national le prévoit" dans un cas précis, explique de son côté M. Le Querrec. Or, "il n'existe pas de disposition ni dans le droit français, ni dans le droit européen qui permette de retirer des contenus relatifs à des émeutes. Aujourd'hui, il n'existe qu'un mécanisme européen de retrait de contenu, c'est le règlement de lutte contre les contenus à caractère terroriste".

"Si un contenu rentre dans la définition européenne du terrorisme, qui est encadré par une directive, il peut y avoir une injonction administrative faite aux plateformes de retirer ce contenu, mais c'est le seul moyen. Dans tous les autres cas, c'est la justice et seule la justice qui peut exiger qu'un contenu soit retiré s'il y a une qualification pénale", ajoute-t-il.

Or, "le Conseil constitutionnel protège particulièrement le droit à la liberté d'expression. Appliqué à la question de la notion de censure, il faut avoir une conception très restreinte des contenus à caractère terroriste qui peuvent faire l'objet d'une censure", rappelle-t-il.

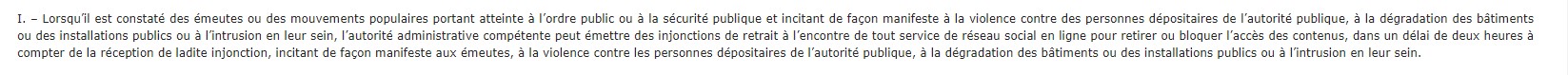

Un amendement sur les contenus relatifs aux émeutes retiré

Dans le cadre de l'examen au Sénat du projet de loi visant à "sécuriser et réguler l'espace numérique", le sénateur LR Patrick Chaize a justement proposé début juillet, quelques jours après les violences urbaines ayant suivies la mort de Nahel, un amendement (lien archivé ici) permettant aux autorités administratives d'émettre "des injonctions de retrait à l’encontre de tout service de réseau social en ligne pour retirer ou bloquer l’accès" à des contenus "incitant de façon manifeste aux émeutes, à la violence contre les personnes dépositaires de l’autorité publique, à la dégradation des bâtiments ou des installations publics ou à l’intrusion en leur sein" dans un délai de "deux heures".

Extrait de l'amendement déposé par le sénateur Patrick Chaize, retiré le 4 juillet 2023

Mais, le sénateur a finalement retiré son amendement, auquel le gouvernement avait donné un "avis très défavorable" en raison du "risque extrêmement élevé d'inconstitutionnalité".

Le ministre chargé de la Transition numérique, Jean-Noël Barrot, a, dans la foulée, proposé la mise en place d'un groupe de travail sur le rôle d'amplification des violences que peuvent jouer les réseaux sociaux.

"Il faut leur mettre des responsabilités, mais si les responsabilités les conduisent à enfreindre la liberté d'expression, alors là ça veut dire que nous n'avons pas tout à fait trouvé les bonnes formules", a déclaré le ministre, appelant à "engager cette réflexion pour que nous puissions d'ici la rentrée trouver une rédaction qui conviendra" (lien archivé ici).

Un risque pour la liberté d'expression ?

Le respect de la liberté d'expression est un des principes qui sous-tend le nouveau règlement européen et des garde-fous sont prévus pour la protéger. Toutefois, il est prématuré de s'avancer sur la façon dont chaque plateforme va appliquer ces principes face à des contenus qui ne sont pas manifestement illicites mais au contraire sujets à interprétation. Ces plateformes - et leurs algorithmes de modération - vont-elles "ratisser large" de peur d'être mises à l'amende ou au contraire adopteront-elles une conception stricte de ce qu'est un contenu illicite ? Les juristes interrogés par l'AFP sont partagés.

"Ce qui est aujourd'hui très compliqué pour ces plateformes, c'est qu'on engage de plus en plus leur responsabilité de manière directe et le mouvement auquel on assiste c'est que les plateformes ne veulent pas prendre de risque. Ce genre de règlement pousse les plateformes à supprimer ce genre de contenus, à créer une forme d'autocensure. Il est possible d'aller devant un juge [pour contester un retrait, NDLR] mais, on le sait, c'est plutôt rare, en raison des délais, du coût. Ce n'est pas quelque chose qui sera très fréquent, à mon avis", estime M. Iteanu, selon qui "en donnant à ces plateformes les clefs d'une nouvelle forme de censure, il y a un vrai risque pour la liberté d'expression".

En outre, "le gouvernement est aujourd'hui dans une stratégie de pression extra-légale. Il dit aux plateformes: je vous demande de retirer des contenus de manière pro-active en utilisant [la non-conformité, NDLR] à vos conditions d'utilisation et si vous ne collaborez pas je modifierai la loi", souligne M. Le Querrec.

"Je ne crois pas trop à la thèse selon laquelle les plateformes vont sur-appliquer le DSA à cause du risque d'amende", estime de son côté M. Couronne. "Les plateformes n'ont pas intérêt à supprimer trop de contenus car ce sont des pertes de revenus pour elles. Si un jour une plateforme est mise à l'amende, ce seront des amendes limitées au moins au début et ce sont des batailles juridiques qui vont durer des années. Entre temps, elles auront compensé ce qu'elles auront pu payer en amende grâce à la publicité et aux données personnelles".

En outre, "le DSA comme les autres textes de notre droit prévoit que la liberté d'expression doit primer. Les plateformes qui vont ratisser large pour éviter d'être sanctionnées pour la présence de contenus illicites pourront être sanctionnées parce qu'elles auront ratissé trop large", ajoute-t-il.

© AGENCE FRANCE-PRESSE | 2024 | Tous droits réservés. L’accès aux contenus de l'AFP publiés sur ce site et, le cas échéant, leur utilisation sont soumis aux conditions générales d'utilisation disponibles sur : https://www.afp.com/fr/cgu. Par conséquent, en accédant aux contenus de l’AFP publiés sur ce site, et en les utilisant, le cas échéant, vous acceptez d'être lié par les conditions générales d'utilisation susmentionnées. L’utilisation de contenus de l'AFP se fait sous votre seule et entière responsabilité.